近日,我校沙巴开户(中国)2021级硕士研究生张家辉以第一作者,史金龙教授为通讯作者,在多媒体TOP期刊IEEE TRANSACTIONS ON MULTIMEDIA上发表了题为“EPM-Net: Efficient Feature Extraction, Point-pair Feature Matching for Robust 6-D Pose Estimation”的高水平学术论文。

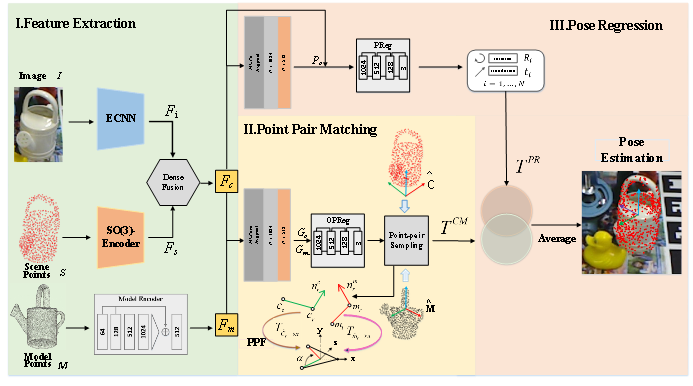

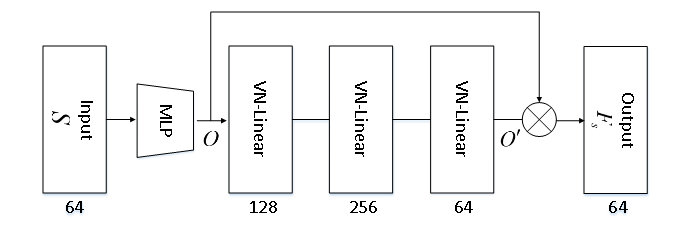

6D位姿估计是指从图像中预测物体的位置和方向,这项技术广泛应用于机器人抓取、增强现实和自动驾驶等领域。本文为了鲁棒地估计出复杂场景下被遮挡物体的6D位姿,提出了一种基于高效特征提取,点对特征匹配的鲁棒6D位姿估计方法。具体来说,首先,该研究提出了二维特征提取模块(ECNN)和点云特征提取模块(SO(3)-Encoder),分别从RGB图像中提取二维特征,从深度图像中提取SO(3)等变特征,这些特征在DenseFusion模块中融合,以获得相机空间中的三维特征;同时,利用CAD先验模型,通过输入模型特征编码器得到模型空间下的三维特征。然后,通过对相机和模型空间中的三维特征进行全局回归,分别生成对应的定向点云并进行点对特征匹配,得到点对匹配姿态信息。最后,对相机和模型空间下的三维特征进行直接姿态回归,将得到的点对特征匹配的位姿信息与直接回归的位姿信息相结合,以提高位姿预测的准确性。该研究提出的方法在YCB-Video,LineMOD和Occlusion LineMOD三个基准数据集上都达到了最先进的性能,尤其是在具有挑战性的Occlusion LineMOD数据集上,达到了74.9%的准确率。

研究结果表明该方法即使在物体严重遮挡的情况下也能实现稳健的性能,为研究机器人抓取方法提供了新的思路。

论文链接:https://ieeexplore.ieee.org/document/10306330